L’Intelligenza Artificiale, con i suoi sviluppi e possibili applicazioni, ha dominato le discussioni degli ultimi mesi. E se, per un attimo, prendessimo una pausa dalle proiezioni future e ci voltassimo ad esaminare le sue radici? A osservare il percorso che ci ha condotti fino ad oggi?

Il nostro obiettivo non è raccontare in maniera esaustiva tutta la storia dell’IA. Vogliamo, piuttosto, tratteggiare il suo percorso evolutivo mettendo in luce cinque momenti chiave, che hanno scandito le tappe fondamentali e rinnovato la domanda, provocatoria, che sorge alle fondamenta di questa tecnologia: è possibile replicare i processi mentali più sofisticati e complessi attraverso l’uso di una macchina?

1. Fabulous 50s

L’idea che una macchina possa possedere le capacità di pensiero umane ci affascinava da sempre. Basti pensare che gli antichi egizi credevano che le statue meccaniche che costruivano possedessero emozioni e saggezza. Solitamente però, il punto di partenza della storia dell’Intelligenza Artificiale viene fissato negli anni ’50, nei cosiddetti fabulous 50s, espressione che riflette l’atmosfera e lo stile di vita associati a quel decennio di prosperità, stabilità e ottimismo.

Gli anni ’50 vengono considerati uno spartiacque per diversi motivi: innanzitutto perché è nel 1955 che il matematico e scienziato americano John McCarthy coniò il termine “Intelligenza Artificiale”.

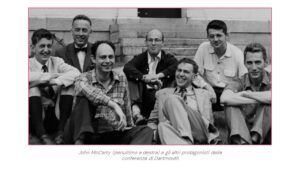

L’anno successivo, nell’agosto del 1956, McCarthy ed altri studiosi, tra cui Marvin Minsky, Nathaniel Rochester, Claude Shannon, tennero la Dartmouth Summer Research Project on Artificial Intelligence, una conferenza in cui discussero una proposta, riassunta in un documento di 17 pagine, d’indirizzo dei propri studi:

“Lo studio procederà sulla base della congettura per cui, in linea di principio, ogni aspetto dell’apprendimento o una qualsiasi altra caratteristica dell’intelligenza possano essere descritte così precisamente da poter costruire una macchina che le simuli”.

La conferenza di Dartmouth segnò la nascita dell’Intelligenza Artificiale come campo di ricerca.

2. Alan Turing – tra IA forte e debole

Qualche anno prima della conferenza di Dartmouth, nel 1950, venne pubblicato sulla rivista Mind uno degli articoli scientifici più celebri della storia: Computing Machinery and Intelligence di Alan Turing.

La riflessione di Alan Turing nasce da un interrogativo: dato che gli umani utilizzano informazioni e ragione per risolvere i problemi, perché non possono farlo anche le macchine?

Per cercare di rispondere a questa domanda Turing ideò un test, conosciuto poi proprio come test di Turing, la cui descrizione è riportata nell’articolo.

Secondo il test di Turing una macchina può essere considerata intelligente se è in grado di sostenere una conversazione con un umano, oltre un certo limite di tempo, senza che questi si accorga che sta comunicando con una macchina. Il test di Turing viene utilizzato ancora oggi, in diverse “versioni”, e, per ora, nessun sistema di Intelligenza Artificiale è riuscito a superarlo.

Il test di Turing non è solo una sorta di esame per le macchine ma serve anche come bussola per orientarci tra questioni di grande rilievo. Può essere collocato all’interno di un panorama di riflessione più vasto che ha preso forma sempre negli anni ’50, quando anche la filosofia ha iniziato ad occuparsi di Intelligenza Artificiale, dando vita a due correnti di pensiero distinte, presenti ancora oggi.

Da un lato, troviamo coloro che sono convinti che, in futuro, le macchine saranno in grado di manifestare un’intelligenza indistinguibile da quella umana: questa interpretazione è detta IA forte. D’altro, c’è chi sostiene che l’Intelligenza Artificiale non riuscirà mai a eguagliare l’intelligenza umana: questa posizione è nota come IA debole. Nel corso degli anni, a seconda degli avanzamenti o delle battute d’arresto nell’ambito dell’informatica e degli studi sull’IA, ha avuto maggiore seguito una o l’altra ipotesi.

3. Deep Blue vs. Garry Kasparov

A proposito di rapporto tra capacità umane e delle macchine, il 10 febbraio 1996, Garry Kasparov– il pluricampione del mondo di scacchi – venne sconfitto in una partita da Deep Blue, un computer della IBM.

Deep Blue era un computer in grado di analizzare 100 milioni di mosse al secondo, progettato unicamente per il gioco degli scacchi. Il suo funzionamento non prevedeva l’apprendimento, ma le notevoli capacità di calcolo gli consentivano di valutare le mosse proprie ed avversarie con largo anticipo.

È doveroso però specificare che dopo quella famosa partita ne seguirono altre e, già l’11 febbraio (il giorno successivo) Kasparov vinse l’incontro. L’ultima sfida avvenne nel 1997, con una nuova e storica vittoria di Deep Blue che venne poi dismesso, eliminando la possibilità di una rivincita.

Sicuramente però la prima partita tra Kasparov e Deep Blue lasciò il segno e può essere considerata come il momento simbolo dei progressi raggiunti in quegli anni. Gli anni ‘80 e ‘90 sono stati segnati da una serie di innovazioni, in particolare nell’ambito del Machine Learning (come, ad esempio, le Reti Neurali back-propagation introdotte da Geoffrey Hinton nel 1986), le cui possibili applicazioni spaziano dalla medicina alla finanza.

Negli anni successivi, le sfide tra umani e computer continuarono sia a scacchi sia ad altri giochi, come il Go, e videro alternarsi come vincitori umani e macchine.

Un esempio abbastanza recente è AlphaGo, un progetto del 2014, sviluppato da Google DeepMind. con l’obiettivo di studiare come applicare le reti neurali profonde al celebre gioco asiatico.

4. Reti Neurali Artificiali e il Web

Quella delle Reti Neurali Artificiali è la storia nella storia dell’Intelligenza Artificiale, caratterizzata dall’alternarsi di momenti di fervida attività e di apparente stasi.

Le prime ricerche sulle Reti Neurali Artificiali iniziarono negli anni ’40, con lo scopo di comprendere il funzionamento del cervello umano e delle connessioni tra neuroni.

Nel 1943 Warren McCulloch e Walter Pitts, un neurofisiologo e un matematico, crearono la prima Rete Neurale Artificiale, che era tuttavia in grado di eseguire solo semplici calcoli e funzioni booleane. Tale fattore provocò una momentanea perdita di interessa nella ricerca. Nel 1958 Frank Rosenblatt introdusse un importante novità: il perceptron (in italiano percettrone), e questa innovazione contribuì a ridare enfasi allo studio delle Reti Neurali Artificiali.

Le Reti Neurali Artificiali rappresentano un cambio di paradigma nel modo dell’IA: l’IA simbolica (o IA classica, approccio tradizionale, presente sino a quel momento) si concentra sull’utilizzo di rappresentazioni esplicite della conoscenza e su regole di inferenza per emulare il ragionamento umano, mentre le Reti Neurali si concentrano sull’apprendimento automatico e sulla modellazione delle relazioni tra i dati.

Marvin Minsky (uno dei “padri” dell’Intelligenza Artificiale che partecipò alla conferenza di Dartmouth) e altri studiosi criticarono in maniera decisa il percettone di Rosenblatt, evidenziandone i limiti e causando un nuovo declino dell’interesse in questo campo.

A metà degli anni ’80, un gruppo di ricercatori del MIT riuscì a superare i limiti evidenziati da Minsky, grazie all’utilizzo e funzionamento di neuroni artificiali multistrato. Tuttavia, a causa della notevole mole di dati necessaria alla fase di addestramento e della grande capacità di calcolo richiesta, fino agli anni 2000 la ricerca e le applicazioni delle Reti Neurali Artificiali stentarono a decollare.

Il vero rinnovamento arrivò nel 2015, grazie all’incremento esponenziale della potenza di calcolo e alla possibilità di accedere ad una fonte di dati in continua evoluzione: il web.

Le applicazioni delle Reti Neurali nel web spaziano dai motori di ricerca, al riconoscimento delle immagini e alle traduzioni automatiche.

Le Reti Neurali hanno rivoluzionato il modo in cui interagiamo con il web, rendendo le nostre esperienze online sempre più efficienti, intuitive e personalizzate. Di conseguenza, l’Intelligenza Artificiale si è trasformata in uno strumento di cui facciamo uso quotidiano, spesso senza nemmeno rendercene conto.

5. 100 anni dalla nascita di Joseph Weizenbaum, il “nonno” di ChatGPT

I primi studiosi di Intelligenza Artificiale (dunque gli esponenti dell’Intelligenza Artificiale classica o simbolica) dedicarono fin da subito particolare attenzione all’elaborazione del linguaggio. Le capacità computazionali dei dispositivi di allora non erano paragonabili a quelle attuali e l’interazione linguistica veniva considerata un buon criterio di valutazione dell’ “intelligenza” di una macchina.

Nel 1966 l’informatico Joseph Weizenbaum creò ELIZA, un chatbot che simulava l’interazione con un terapeuta Rogersiano. Pur avendo vita breve, ELIZA rappresenta una pietra miliare poiché fu la prima volta che un programmatore sviluppò un’interazione uomo-macchina con l’obiettivo specifico di creare l’illusione di un dialogo uomo-uomo.

Weizenbaum viene oggi ricordato come il “nonno” dei moderni chatbot e, a 100 anni dalla sua nascita (Berlino, 8 gennaio 1923), la sua storia risulta estremamente attuale.

Non fu solo l’inventore dell’antenato dei chatbot, ma fu anche tra i primi a evidenziare criticità etiche e la necessità di regole quando ci si trova davanti a una rivoluzione tecnologica così impattante come quella dell’Intelligenza Artificiale.

Weizenbaum fu notevolmente stupito dalle reazioni delle persone di fronte a quel primo assaggio di IA. Rimase così colpito dalla facilità con cui le persone si facevano coinvolgere quando interagivano con le macchine, dalla propensione a confidare i pensieri più remoti, dalla diffusa credenza che questi sistemi potessero essere la soluzione definitiva a diversi problemi, che decise di abbandonare le ricerche in ambito informatico per dedicarsi alla riflessione sul rapporto fra esseri umani e macchine.

L’esperienza di Joseph Weizenbaum ed ELIZA non è solo un tassello fondamentale nella storia dell’Intelligenza Artificiale, ma rappresenta anche un promemoria: mentre continuiamo a progredire nel campo dell’IA, è essenziale continuare ad interrogarsi ed affrontare le questioni etiche ad essa correlate.

Solo in questo modo potremo sfruttare appieno le opportunità offerte dall’Intelligenza Artificiale, garantendo al contempo sicurezza, equità e benessere per tutti.